- 17.2 创建RAID磁盘阵列

17.2 创建RAID磁盘阵列

既然要使用iSCSI存储技术为远程用户提供共享存储资源,首先要保障用于存放资源的服务器的稳定性与可用性,否则一旦在使用过程中出现故障,则维护的难度相较于本地硬盘设备要更加复杂、困难。因此推荐各位读者按照本书第7章讲解的知识来部署RAID磁盘阵列组,确保数据的安全性。下面以配置RAID 5磁盘阵列组为例进行讲解。考虑到第7章已经事无巨细地讲解了RAID磁盘阵列技术和配置方法,因此本节不会再重复介绍相关参数的意义以及用途,忘记了的读者可以翻回去看一下。

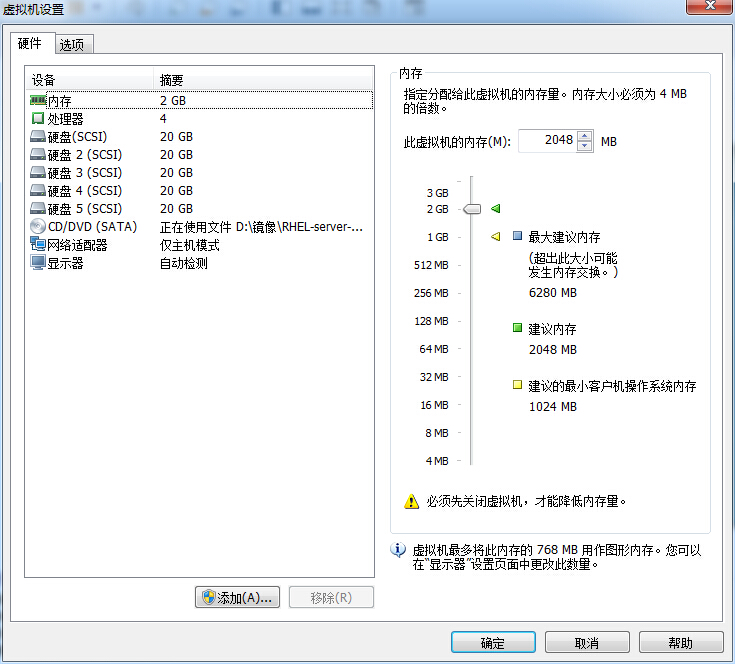

首先在虚拟机中添加4块新硬盘,用于创建RAID 5磁盘阵列和备份盘,如图17-2所示。

图17-2 添加4块用于创建RAID 5级别磁盘阵列的新硬盘

启动虚拟机系统,使用mdadm命令创建RAID磁盘阵列。其中,-Cv参数为创建阵列并显示过程,/dev/md0为生成的阵列组名称,-n 3参数为创建RAID 5磁盘阵列所需的硬盘个数,-l 5参数为RAID磁盘阵列的级别,-x 1参数为磁盘阵列的备份盘个数。在命令后面要逐一写上使用的硬盘名称。另外,还可以使用第3章讲解的通配符来指定硬盘设备的名称,有兴趣的读者可以试一下。

- [root@linuxprobe ~]# mdadm -Cv /dev/md0 -n 3 -l 5 -x 1 /dev/sdb /dev/sdc /dev/sdd /dev/sde

- mdadm: layout defaults to left-symmetric

- mdadm: layout defaults to left-symmetric

- mdadm: chunk size defaults to 512K

- mdadm: size set to 20954624K

- mdadm: Defaulting to version 1.2 metadata

- mdadm: array /dev/md0 started.

在上述命令成功执行之后,得到一块名称为/dev/md0的新设备,这是一块RAID 5级别的磁盘阵列,并且还有一块备份盘为硬盘数据保驾护航。大家可使用mdadm -D命令来查看设备的详细信息。另外,由于在使用远程设备时极有可能出现设备识别顺序发生变化的情况,因此,如果直接在fstab挂载配置文件中写入/dev/sdb、/dev/sdc等设备名称的话,就有可能在下一次挂载了错误的存储设备。而UUID值是设备的唯一标识符,可以用于精确地区分本地或远程设备。于是我们可以把这个值记录下来,一会儿准备填写到挂载配置文件中。

- [root@linuxprobe ~]# mdadm -D /dev/md0

- /dev/md0:

- Version : 1.2

- Creation Time : Thu Sep 24 21:59:57 2017

- Raid Level : raid5

- Array Size : 41909248 (39.97 GiB 42.92 GB)

- Used Dev Size : 20954624 (19.98 GiB 21.46 GB)

- Raid Devices : 3

- Total Devices : 4

- Persistence : Superblock is persistent

- Update Time : Thu Sep 24 22:02:23 2017

- State : clean

- Active Devices : 3

- Working Devices : 4

- Failed Devices : 0

- Spare Devices : 1

- Layout : left-symmetric

- Chunk Size : 512K

- Name : linuxprobe.com:0 (local to host linuxprobe.com)

- UUID : 3370f643:c10efd6a:44e91f2a:20c71f3e

- Events : 26

- Number Major Minor RaidDevice State

- 0 8 16 0 active sync /dev/sdb

- 1 8 32 1 active sync /dev/sdc

- 4 8 48 2 active sync /dev/sdd

- 3 8 64 - spare /dev/sde